I dagens skumle/kule vitenskapsnyheter har amerikanske forskere tatt et betydelig skritt fremover for å lage datamaskiner som kommuniserer direkte med hjernen vår.

Nevrovitere og taleeksperter ved University of California San Francisco (UCSF) har utviklet en kunstig intelligens som kan lese menneskelige hjernebølger og konvertere dem til tale.

Gjennombruddet, først rapportert i Natur magasin, har implikasjoner både for mennesker som har tilstander som har kostet dem talekraften (for eksempel MS eller slaglidere), og for den fremtidige robotapokalypsen. De kan bokstavelig talt lese tankene våre nå gutta. Er det på tide å bekymre seg?

Alle vitser til side, denne teknologien er helt banebrytende for sømløs integrering av maskiner i menneskelige mekanismer, noe som potensielt reduserer behovet for brukerinnspill i programmering. Endelig vil MS Paint forstå at det du klarte å lage IRL ikke var faktisk hva var i hodet ditt.

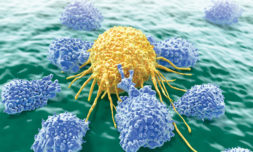

Brainwave to speech intelligence har gjort raske fremskritt de siste ti årene, etter å ha stoppet tidligere med å oversette rå hjernedata til ord. Kompleksiteten til nevrologiske veier, og individualiteten til hver persons hjernemønster, betydde at det vanligvis bare var mulig å generere ett ord om gangen.

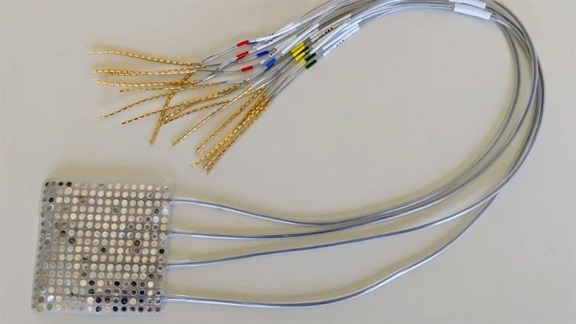

Selv om folks tankemønstre er unike og uendelig komplekse, er signalene fra hjernen til munnen, kjeven og tungen som er relativt universelle. Derfor, i stedet for å studere bare hjernen, brukte UCSF -forskerne to AI -er for å analysere både nevrologiske signaler og bevegelser i munnen under dialog.

Videoen nedenfor viser deg et røntgenbilde av hvordan munnen og halsen vår faktisk ser ut når vi snakker.

Da informasjonen som ble samlet inn av disse AI -ene ble matet inn i en synthesizer, kom det ut noe som mer eller mindre lignet komplekse setninger.