Nelle notizie scientifiche spaventose/fredde del giorno, gli scienziati statunitensi hanno compiuto un significativo passo avanti nella creazione di computer che comunicano direttamente con il nostro cervello.

Neuroscienziati ed esperti di linguaggio dell'Università della California a San Francisco (UCSF) hanno sviluppato un'intelligenza artificiale in grado di leggere le onde cerebrali umane e convertirle in parole.

La svolta, riportata per la prima volta in Natura rivista, ha implicazioni sia per le persone che hanno condizioni che sono costate loro il potere della parola (malati di SM o ictus, per esempio), sia per la futura apocalisse dei robot. Possono letteralmente leggere i nostri pensieri ora ragazzi è il momento di preoccuparsi?

Scherzi a parte, questa tecnologia è completamente rivoluzionaria per la perfetta integrazione delle macchine nei meccanismi umani, riducendo potenzialmente la necessità di input da parte dell'utente nella programmazione. Infine, MS Paint capirà che ciò che sei riuscito a creare IRL non lo era effettivamente cosa c'era nella tua testa.

L'intelligenza da brainwave to speech ha fatto rapidi progressi negli ultimi dieci anni, dopo essersi fermato in passato nella traduzione di dati cerebrali grezzi in parole. La complessità dei percorsi neurologici e l'individualità del modello cerebrale di ogni persona hanno fatto sì che generalmente fosse possibile generare solo una parola alla volta.

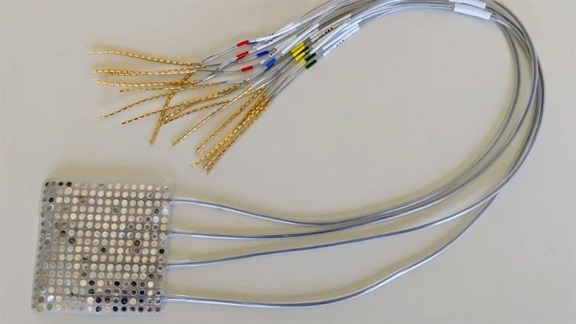

Tuttavia, mentre i modelli di pensiero delle persone sono unici e infinitamente complessi, i segnali dal cervello alla bocca, alla mascella e alla lingua che producono la parola sono abbastanza universali. Quindi, invece di studiare solo il cervello, gli scienziati dell'UCSF hanno utilizzato due IA per analizzare sia i segnali neurologici che i movimenti della bocca durante il dialogo.

Il video qui sotto mostra una vista a raggi X di come appaiono effettivamente la nostra bocca e la nostra gola quando parliamo.

Quando le informazioni raccolte da queste IA venivano inserite in un sintetizzatore, veniva fuori qualcosa che assomigliava più o meno a frasi complesse.