Suscitant de nouvelles inquiétudes quant à l'influence de la plateforme sur les enfants, de nouvelles recherches ont révélé que son algorithme pousse des vidéos sur les troubles de l'alimentation et l'automutilation aux jeunes de 13 ans.

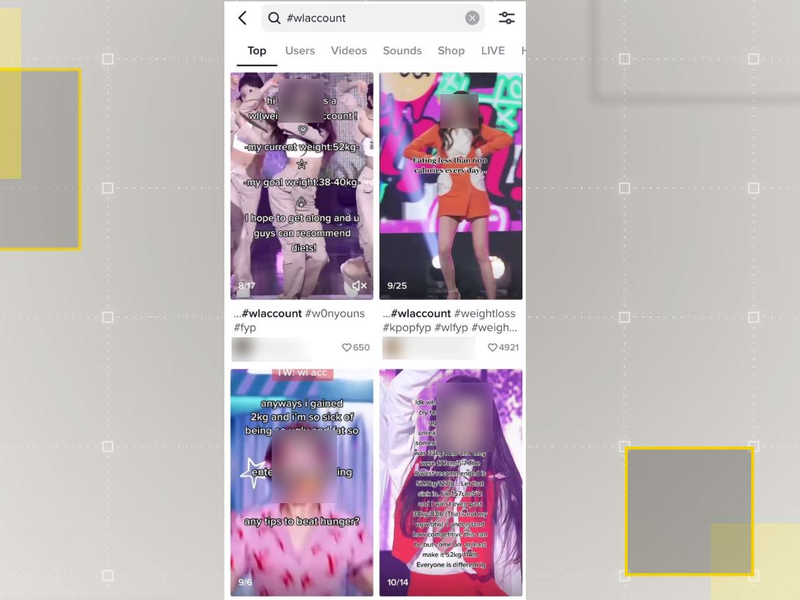

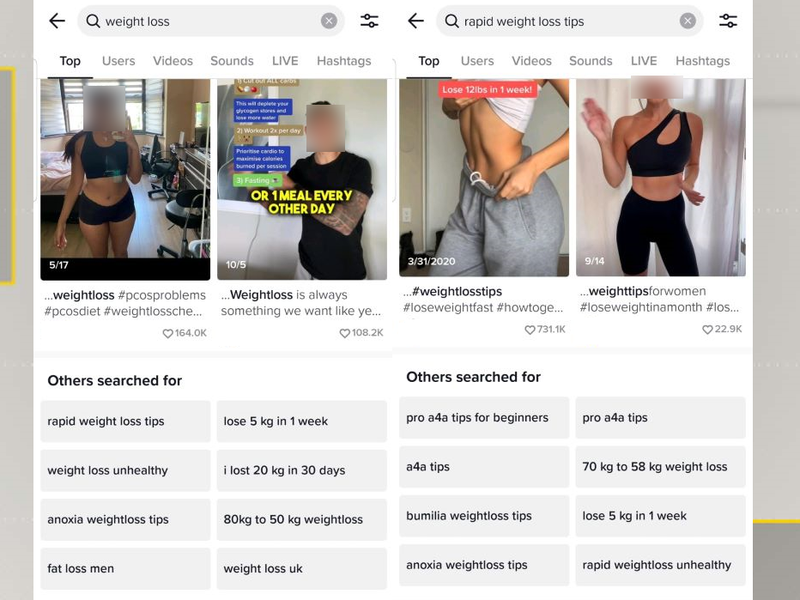

Selon une étude du Center for Countering Digital Hate (CCDH), TikTok semble diffuser des vidéos sur les troubles de l'alimentation et l'automutilation chez les enfants dès l'âge de 13 ans.

La étude, qui a examiné le puissant algorithme de la plate-forme, a trouvé des comptes faisant la promotion du suicide en 2.6 minutes, et d'autres recommandant des clips pro-minceur explicites en huit minutes.

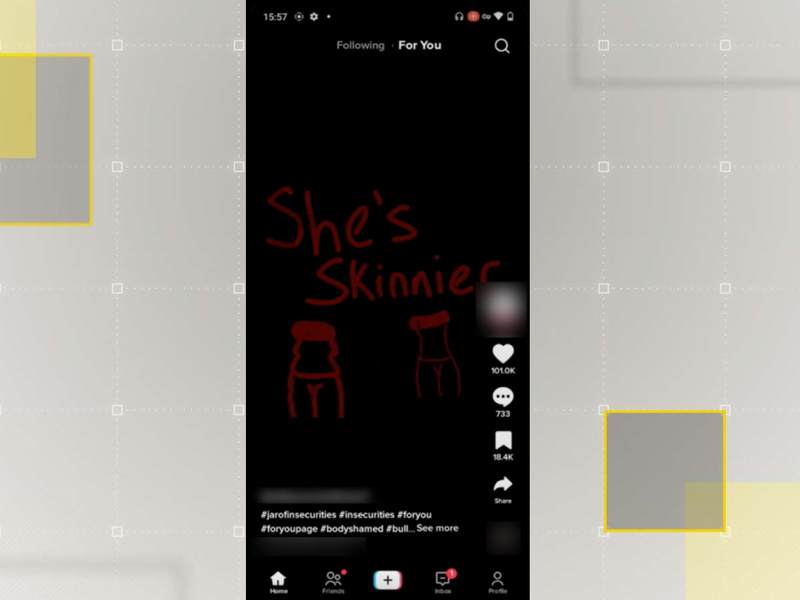

Les chercheurs ont découvert que les pages For You des comptes qu'ils avaient créés et présentant des caractéristiques d'adolescents vulnérables étaient inondées de contenu de cette nature. douze fois plus que les comptes standards.

Cela a déclenché de nouvelles préoccupations sur l'influence de l'application sur les utilisateurs impressionnables.

Il intervient alors que les législateurs des États et fédéraux aux États-Unis chercher des moyens de sévir sur TikTok sur les craintes de confidentialité et de sécurité, ainsi que la détermination si oui ou non la plateforme est appropriée pour les adolescents.

Il suit également une série d'enquêtes de septembre à l'échec de TikTok à informer sa base d'utilisateurs de 25 % de 10 à 19 ans qu'il avait traité leurs données sans consentement ni fondement juridique nécessaire.

Après quoi, l'entreprise s'est engagée à changer, mais les dernières conclusions du CCDH suggérer le contraire.

"Les résultats sont le cauchemar de tous les parents : les flux des jeunes sont bombardés de contenus nocifs et déchirants qui peuvent avoir un impact cumulatif significatif sur leur compréhension du monde qui les entoure et sur leur santé physique et mentale", a écrit Imran Ahmed, PDG du CCDH, dans le rapport intitulé Mortel par conception.