En las noticias científicas aterradoras / geniales del día, los científicos de EE. UU. Han dado un paso importante en la creación de computadoras que se comunican directamente con nuestro cerebro.

Los neurocientíficos y los expertos en habla de la Universidad de California en San Francisco (UCSF) han desarrollado una inteligencia artificial que es capaz de leer las ondas cerebrales humanas y convertirlas en habla.

El avance, reportado por primera vez en Naturaleza revista, tiene implicaciones tanto para las personas que padecen afecciones que les han costado el poder del habla (EM o personas que sufren un derrame cerebral, por ejemplo), como para el futuro apocalipsis de los robots. Ellos pueden leer literalmente nuestros pensamientos ahora, chicos, ¿es hora de preocuparse?

Dejando las bromas a un lado, esta tecnología es completamente innovadora para la integración perfecta de las máquinas en los mecanismos humanos, lo que potencialmente reduce la necesidad de participación del usuario en la programación. Finalmente, MS Paint entenderá que lo que logró crear IRL no fue lo que estaba en tu cabeza.

Las ondas cerebrales a la inteligencia del habla ha progresado rápidamente en los últimos diez años, habiéndose estancado en el pasado en la traducción de datos cerebrales sin procesar en palabras. La complejidad de las vías neurológicas y la individualidad del patrón cerebral de cada persona significaba que, en general, solo era posible generar una palabra a la vez.

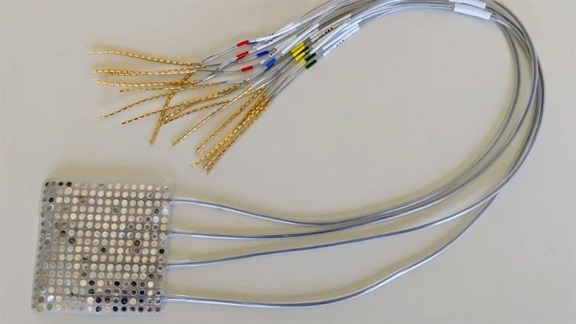

Sin embargo, aunque los patrones de pensamiento de las personas son únicos e infinitamente complejos, las señales del cerebro a la boca, la mandíbula y la lengua que producen el habla son bastante universales. Por lo tanto, en lugar de estudiar solo el cerebro, los científicos de la UCSF utilizaron dos IA para analizar tanto las señales neurológicas como los movimientos de la boca durante el diálogo.

El siguiente video muestra una vista de rayos X de cómo se ven realmente nuestra boca y garganta cuando hablamos.

Cuando la información recopilada por estas IA se introdujo en un sintetizador, salió algo que se parecía más o menos a oraciones complejas.