Dans l'actualité scientifique effrayante / cool du jour, les scientifiques américains ont fait un pas en avant important dans la création d'ordinateurs qui communiquent directement avec notre cerveau.

Des neuroscientifiques et des experts en parole de l'Université de Californie à San Francisco (UCSF) ont développé une intelligence artificielle capable de lire les ondes cérébrales humaines et de les convertir en parole.

La percée, signalée pour la première fois en Nature magazine, a des implications à la fois pour les personnes atteintes de maladies qui leur ont coûté le pouvoir de la parole (les victimes de la SEP ou d'un AVC, par exemple) et pour la future apocalypse des robots. Ils peuvent littéralement lire nos pensées maintenant, les gars, est-il temps de s'inquiéter?

Blague à part, cette technologie est complètement révolutionnaire pour l'intégration transparente des machines dans les mécanismes humains, réduisant potentiellement le besoin d'intervention de l'utilisateur dans la programmation. Enfin, MS Paint comprendra que ce que vous avez réussi à créer IRL n'était pas actually ce qui était dans ta tête.

L'intelligence des ondes cérébrales à la parole a fait des progrès rapides au cours des dix dernières années, après avoir stagné dans le passé à traduire les données brutes du cerveau en mots. La complexité des voies neurologiques et l'individualité du schéma cérébral de chaque personne signifiaient qu'il n'était généralement possible de générer qu'un mot à la fois.

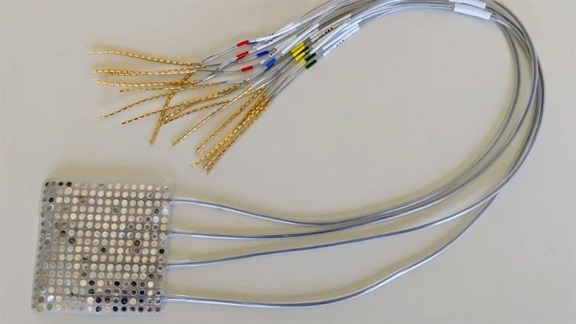

Cependant, alors que les schémas de pensée des gens sont uniques et infiniment complexes, les signaux du cerveau à la bouche, à la mâchoire et à la langue qui produisent la parole sont assez universels. Ainsi, plutôt que d'étudier uniquement le cerveau, les scientifiques de l'UCSF ont utilisé deux IA pour analyser à la fois les signaux neurologiques et les mouvements de la bouche pendant le dialogue.

La vidéo ci-dessous vous montre une vue radiographique de ce à quoi ressemblent réellement notre bouche et notre gorge lorsque nous parlons.

Lorsque les informations collectées par ces IA ont été introduites dans un synthétiseur, quelque chose qui ressemblait plus ou moins à des phrases complexes est sorti.