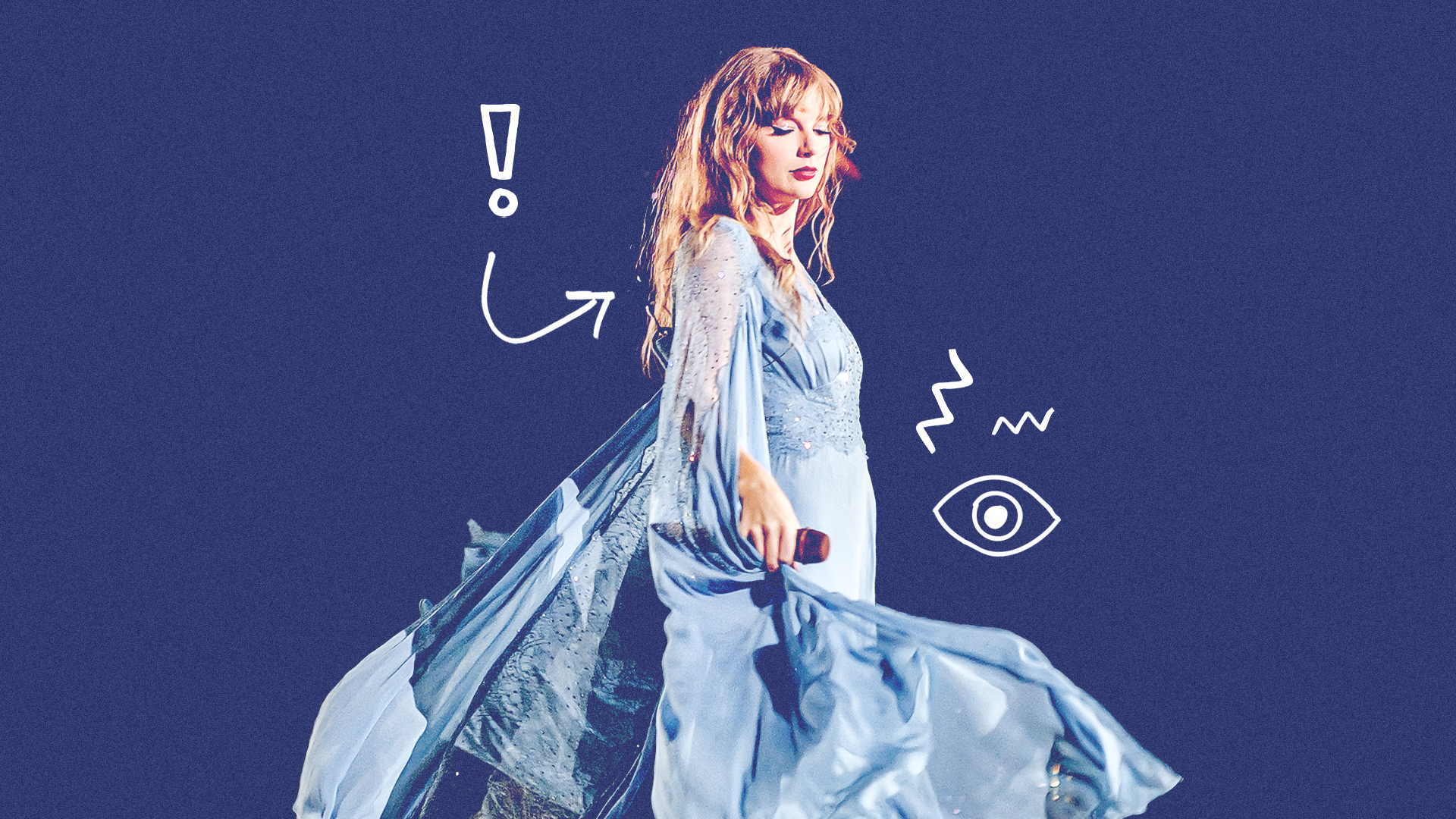

La semaine dernière, des images explicites de Taylor Swift créées à l'aide de l'IA ont été partagées sur Twitter (X), certaines publications ayant été vues des millions de fois. La panique juridique qui s’ensuit pourrait avoir des conséquences sur l’utilisation de l’image de célébrités et des images d’IA en général.

Taylor Swift a été victime de la génération d'images IA la semaine dernière. Des images explicites et pornographiques ont été créées sans son consentement et partagées sur X (anciennement Twitter) par des milliers d'utilisateurs.

Les messages ont été consultés des dizaines de millions de fois avant d’être supprimés et effacés de la plateforme.

Les retombées ont été rapides, X ayant peaufiné ses filtres de censure au cours du week-end pour supprimer toute mention des images. Les hommes politiques américains sont réclamer de nouvelles lois pour criminaliser les deepfakes en conséquence directe, et Microsoft s'est engagé à pousser davantage de garde-fous sur son application Designer IP afin de prévenir de futurs incidents.

La publication d'images de nudité non consensuelle (NCN) est strictement interdite sur X et nous appliquons une politique de tolérance zéro à l'égard de ce type de contenu. Nos équipes suppriment activement toutes les images identifiées et prennent les mesures appropriées contre les comptes responsables de leur publication. Nous sommes étroitement…

— Sécurité (@Sécurité) 26 janvier 2024

Ces derniers développements dans la controverse sur les deepfakes font suite à de nombreuses années de contenu pornographique contraire à l’éthique en ligne, dont la plupart privent les victimes de leur autonomie quant à leur image. C’est un problème qui concerne à la fois les célébrités et les gens ordinaires, à mesure que les outils d’IA deviennent de plus en plus courants et accessibles à tous.

Le statut de haut niveau de Taylor et ses fans dévoués ont contribué à placer cette question au premier plan de l'actualité et alerteront sans aucun doute les décideurs politiques, les plateformes de médias sociaux et les entreprises technologiques d'une manière que nous n'avons jamais vue jusqu'à présent.

Même si des changements et des lois plus strictes auraient dû être mis en place depuis longtemps, nous verrons probablement des progrès indispensables dans les semaines et les mois à venir. Les conséquences pourraient être considérables et affecter la génération d’images IA en général – et pas seulement les ressemblances de célébrités ou le contenu explicite.

Comment les conséquences juridiques pourraient-elles affecter la génération d’images IA à l’avenir ?

Alors, qu'est- spécifiquement Est-ce que cela se passe légalement pour lutter contre le contenu deepfake AI de Taylor ?

Mardi, un groupe bipartisan de sénateurs américains présenté un projet de loi cela criminaliserait la diffusion d’images sexualisées et non consensuelles générées par l’IA. Cela permettrait aux victimes de demander une sanction civile contre « les individus qui ont produit ou possédé le faux dans l'intention de le distribuer ».

De plus, toute personne recevant des images ou du matériel sachant qu’ils n’ont pas été créés avec le consentement serait également concernée.

Dick Durbin, whip de la majorité au Sénat américain, et les sénateurs Lindsey Graham, Amy Klobuchar et Josh Hawley sont à l'origine du projet de loi. Il s'agit de la « Loi de 2024 sur la perturbation des images falsifiées explicites et des modifications non consensuelles », ou « Loi de défi » pour faire court.

Les photos explicites de Taylor sont également parvenues à la Maison Blanche. La secrétaire de presse Karine Jean-Pierre a déclaré vendredi à ABC News que le gouvernement était "alarmé par les informations faisant état de la circulation d'images".

Tout cela fait suite à une projet de loi appelé No AI FRAUD Act qui a été présenté le 10 janvierth 2024.

Cela vise à créer une « protection fédérale de base contre les abus de l’IA » et à faire respecter les droits en ligne du premier amendement. Il met particulièrement l’accent sur les droits des individus à leur image et à s’exprimer contre les contrefaçons d’IA. Si elle est adoptée, la loi No AI FRAUD Act « réaffirmerait que l'image et la voix de chacun sont protégées et donnerait aux individus le droit de contrôler l'utilisation de leurs caractéristiques d'identification ».

Bien sûr, la protection juridique est une chose. l'application le faire à l'échelle du réseau en est une autre. Il y a aussi la question controversée de la liberté d'expression et d’expression – et déterminer où se situe la punition.

Les plateformes logicielles de médiation qui rendent possibles les images d’IA devraient-elles être restreintes ou sanctionnées ? Nous ne limitons pas Photoshop, par exemple, bien qu'il s'agisse d'un outil important pour créer des images trompeuses. Quelle devrait être la position juridique des entreprises d’IA dans ce domaine ? Ce n’est pas clair actuellement.

Les législateurs proposent un projet de loi anti-consensuel sur la pornographie artificielle après la controverse sur Taylor Swift https://t.co/3PS8h0ULxO

- Le Verge (@verge) 31 janvier 2024