W przerażających/fajnych wiadomościach naukowych dnia amerykańscy naukowcy poczynili znaczący krok naprzód w tworzeniu komputerów, które komunikują się bezpośrednio z naszymi mózgami.

Neuronaukowcy i eksperci od mowy z Uniwersytetu Kalifornijskiego w San Francisco (UCSF) opracowali sztuczną inteligencję, która potrafi odczytywać ludzkie fale mózgowe i przekształcać je w mowę.

Przełom, po raz pierwszy zgłoszony w Natura ma znaczenie zarówno dla osób cierpiących na schorzenia, które kosztowały ich zdolność mowy (na przykład cierpiących na stwardnienie rozsiane lub udar), jak i dla przyszłej apokalipsy robotów. Teraz mogą dosłownie czytać w naszych myślach, czy czas się martwić?

Żarty na bok, ta technologia jest całkowicie przełomowa dla bezproblemowej integracji maszyn z ludzkimi mechanizmami, potencjalnie zmniejszając potrzebę wprowadzania danych przez użytkownika w programowanie. Wreszcie MS Paint zrozumie, że to, co udało ci się stworzyć IRL, nie było faktycznie co było w twojej głowie.

Fala mózgowa do inteligencji mowy poczyniła szybkie postępy w ciągu ostatnich dziesięciu lat, ponieważ w przeszłości utknęła w tłumaczeniu surowych danych mózgowych na słowa. Złożoność ścieżek neurologicznych i indywidualność wzorców mózgowych każdej osoby oznaczały, że na ogół możliwe było wygenerowanie tylko jednego słowa na raz.

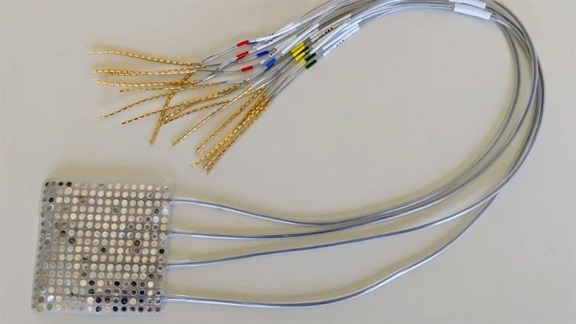

Jednakże, podczas gdy wzorce myślowe ludzi są unikalne i nieskończenie złożone, sygnały z mózgu do ust, szczęki i języka, które wytwarzają mowę, są dość uniwersalne. Dlatego zamiast badać tylko mózg, naukowcy z UCSF wykorzystali dwie AI do analizy zarówno sygnałów neurologicznych, jak i ruchów ust podczas dialogu.

Poniższy film przedstawia prześwietlenie rentgenowskie tego, jak faktycznie wyglądają nasze usta i gardło, kiedy rozmawiamy.

Kiedy informacje zebrane przez te AI zostały wprowadzone do syntezatora, wyszło coś, co mniej lub bardziej przypominało złożone zdania.