今日の恐ろしい/クールな科学ニュースでは、米国の科学者は私たちの脳と直接通信するコンピューターの作成において大きな一歩を踏み出しました。

カリフォルニア大学サンフランシスコ校(UCSF)の神経科学者と音声専門家は、人間の脳波を読み取って音声に変換できる人工知能を開発しました。

ブレークスルー、最初に報告された 自然 雑誌は、彼らにスピーチの力を犠牲にした状態を持っている人々(例えば、MSまたは脳卒中患者)と将来のロボットの黙示録の両方に影響を及ぼします。 彼らは文字通り私たちの考えを読むことができます。

冗談はさておき、この技術は、機械を人間のメカニズムにシームレスに統合するための完全に画期的なものであり、プログラミングでのユーザー入力の必要性を減らす可能性があります。 最後に、MSペイントは、IRLを作成するために管理したものがそうではなかったことを理解します 実際に あなたの頭の中に何があったのか。

脳波から音声へのインテリジェンスは、過去XNUMX年間で急速な進歩を遂げ、過去に生の脳データを単語に翻訳することで行き詰まりました。 神経経路の複雑さ、および各人の脳のパターンの個性は、一般的に一度にXNUMXつの単語しか生成できないことを意味しました。

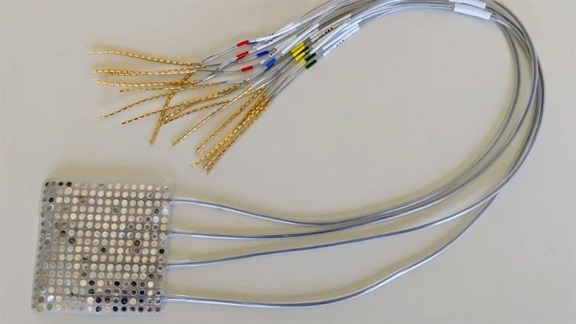

しかし、人々の思考パターンは独特で無限に複雑ですが、音声を生成する脳から口、顎、舌への信号はかなり普遍的です。 したがって、UCSFの科学者は、脳だけを研究するのではなく、XNUMXつのAIを使用して、対話中の神経信号と口の動きの両方を分析しました。

下のビデオは、私たちが話しているときに私たちの口と喉が実際にどのように見えるかをX線で示しています。

これらのAIによって収集された情報がシンセサイザーに送られると、多かれ少なかれ複雑な文に似たものが出てきました。