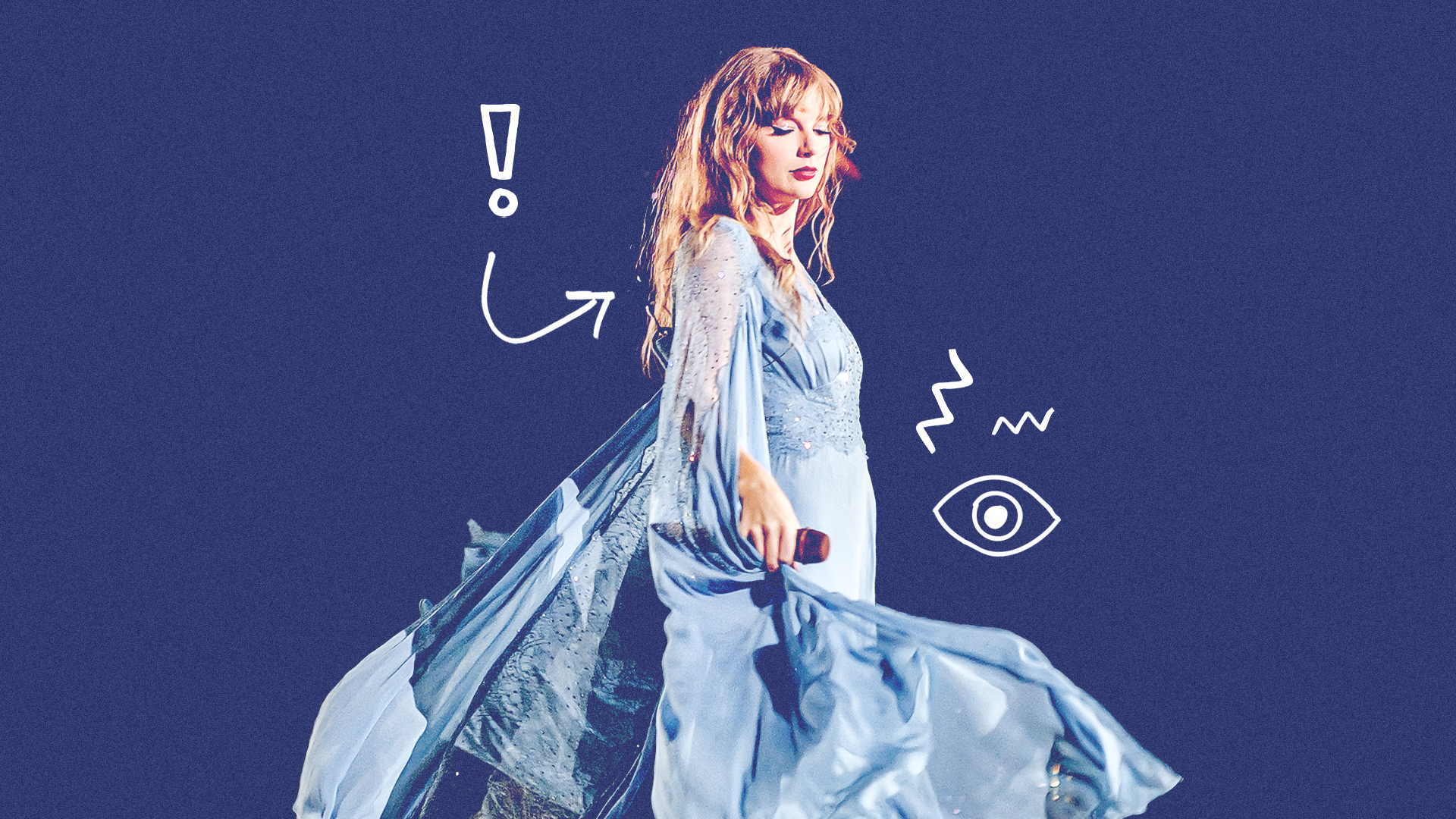

La settimana scorsa, immagini esplicite di Taylor Swift create utilizzando l'intelligenza artificiale sono state condivise su Twitter (X), con alcuni post che hanno ottenuto milioni di visualizzazioni. Il conseguente panico legale potrebbe avere conseguenze sull’uso delle sembianze di celebrità e delle immagini IA in generale.

Taylor Swift è stata vittima della generazione di immagini tramite intelligenza artificiale la scorsa settimana. Immagini pornografiche esplicite sono state create senza il suo consenso e condivise su X (formalmente Twitter) da migliaia di utenti.

I post sono stati visualizzati decine di milioni di volte prima di essere rimossi e cancellati dalla piattaforma.

La conseguente ricaduta è stata rapida, con X che ha modificato i suoi filtri di censura durante il fine settimana per rimuovere qualsiasi menzione delle immagini. I politici americani lo sono chiedendo nuove leggi criminalizzare i deepfake come conseguenza diretta e Microsoft si è impegnata a introdurre più guardrail sulla sua app Designer IP per prevenire incidenti futuri.

Pubblicare immagini di nudo non consensuale (NCN) è severamente vietato su X e abbiamo una politica di tolleranza zero nei confronti di tali contenuti. I nostri team stanno rimuovendo attivamente tutte le immagini identificate e adottando le azioni appropriate contro gli account responsabili della loro pubblicazione. Siamo strettamente...

— Sicurezza (@Sicurezza) Gennaio 26, 2024

Questi ultimi sviluppi nella controversia sui deepfake fanno seguito a molti anni di contenuti pornografici non etici online, la maggior parte dei quali priva le vittime dell’autonomia riguardo alle loro sembianze. È un problema che riguarda sia le celebrità che la gente comune, poiché gli strumenti di intelligenza artificiale diventano più comuni e accessibili a chiunque.

Lo status di alto profilo di Taylor e la devota base di fan hanno contribuito a portare questo problema in prima linea nelle notizie attuali e senza dubbio allerteranno i politici, le piattaforme di social media e le aziende tecnologiche in un modo mai visto prima.

Anche se il cambiamento e leggi più severe avrebbero dovuto essere messi in atto molto tempo fa, è probabile che vedremo i progressi tanto necessari nelle prossime settimane e nei prossimi mesi. Le ramificazioni potrebbero essere di vasta portata e influenzare la generazione di immagini dell’intelligenza artificiale in generale, non solo le somiglianze di celebrità o contenuti espliciti.

In che modo le ricadute legali potrebbero influenzare la generazione di immagini AI in futuro?

Allora, che cosa in particolare sta accadendo legalmente per combattere i contenuti deepfake dell'intelligenza artificiale di Taylor?

Martedì si è riunito un gruppo bipartisan di senatori americani ha presentato una proposta di legge ciò criminalizzerebbe la diffusione di immagini non consensuali e sessualizzate generate dall’intelligenza artificiale. Ciò consentirebbe alle vittime di richiedere una sanzione civile contro "gli individui che hanno prodotto o posseduto il falso con l'intento di distribuirlo".

Inoltre, sarebbe interessato anche chiunque riceva immagini o materiale sapendo che non sono stati creati con il consenso.

Dietro il disegno di legge ci sono Dick Durbin, presidente della maggioranza al Senato americano, e i senatori Lindsey Graham, Amy Klobuchar e Josh Hawley. Si chiama "Disrupt Explicit Forged Images and Non-Consensual Edits Act of 2024", o "Legge di sfida" in breve.

Le foto esplicite di Taylor sono arrivate anche alla Casa Bianca. La portavoce Karine Jean-Pierre ha detto venerdì alla ABC News che il governo è "allarmato dalle notizie di immagini in circolazione".

Tutto ciò deriva da un altro disegno di legge chiamato No AI FRAUD Act, introdotto il 10 gennaioth 2024.

L’obiettivo è creare una “protezione federale di base contro l’abuso dell’intelligenza artificiale” e sostenere i diritti del Primo Emendamento online. Pone particolare enfasi sui diritti di un individuo alla propria immagine e voce contro le contraffazioni dell'intelligenza artificiale. Se approvato, il No AI FRAUD Act "riaffermerebbe che l'immagine e la voce di ognuno sono protette e darebbe agli individui il diritto di controllare l'uso delle proprie caratteristiche identificative".

Naturalmente la tutela giuridica è una cosa far rispettare esso su base netta è un altro. C'è anche la controversa questione della libertà di parola ed espressione – e determinare dove si trova la punizione.

Le piattaforme software intermediarie che rendono possibili le immagini di intelligenza artificiale dovrebbero essere limitate o punite? Non limitiamo Photoshop, ad esempio, nonostante sia uno strumento importante per creare immagini fuorvianti. Dove dovrebbero posizionarsi legalmente le aziende di intelligenza artificiale? Al momento non è chiaro.

I legislatori propongono un disegno di legge anti-non consensuale sulla pornografia basata sull'intelligenza artificiale dopo la controversia su Taylor Swift https://t.co/3PS8h0ULxO

- The Verge (@verge) Gennaio 31, 2024