Nas notícias científicas assustadoras / legais do dia, os cientistas dos EUA deram um passo significativo na criação de computadores que se comunicam diretamente com nossos cérebros.

Neurocientistas e especialistas em fala da Universidade da Califórnia em San Francisco (UCSF) desenvolveram uma inteligência artificial que é capaz de ler ondas cerebrais humanas e convertê-las em fala.

O avanço, relatado pela primeira vez em Natureza revista, tem implicações tanto para as pessoas que têm condições que lhes custaram o poder da fala (portadores de esclerose múltipla ou derrame, por exemplo), e para o futuro apocalipse do robô. Eles podem literalmente ler nossos pensamentos agora, pessoal, é hora de se preocupar?

Piadas à parte, essa tecnologia é totalmente inovadora para a integração perfeita de máquinas em mecanismos humanos, reduzindo potencialmente a necessidade de entrada do usuário na programação. Finalmente, o MS Paint vai entender que o que você conseguiu criar IRL não foi o que estava na sua cabeça.

As ondas cerebrais para a inteligência da fala progrediram rapidamente nos últimos dez anos, tendo travado no passado a tradução de dados cerebrais brutos em palavras. A complexidade das vias neurológicas e a individualidade do padrão cerebral de cada pessoa significava que geralmente só era possível gerar uma palavra por vez.

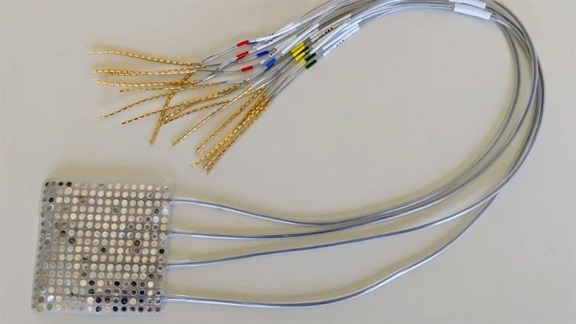

No entanto, embora os padrões de pensamento das pessoas sejam únicos e infinitamente complexos, os sinais do cérebro para a boca, mandíbula e língua que produzem a fala são bastante universais. Portanto, em vez de estudar apenas o cérebro, os cientistas da UCSF usaram dois IAs para analisar os sinais neurológicos e os movimentos da boca durante o diálogo.

O vídeo abaixo mostra uma radiografia de como a boca e a garganta realmente parecem quando conversamos.

Quando as informações coletadas por esses IAs foram alimentadas em um sintetizador, algo que mais ou menos se assemelhava a frases complexas saiu.