Despertando novas preocupações sobre a influência da plataforma nas crianças, uma nova pesquisa descobriu que seu algoritmo está enviando vídeos sobre distúrbios alimentares e automutilação para crianças de 13 anos.

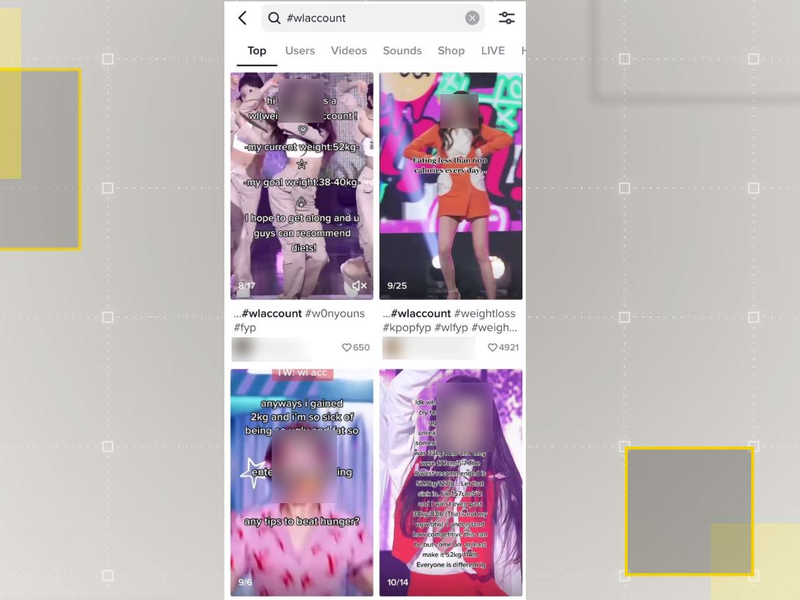

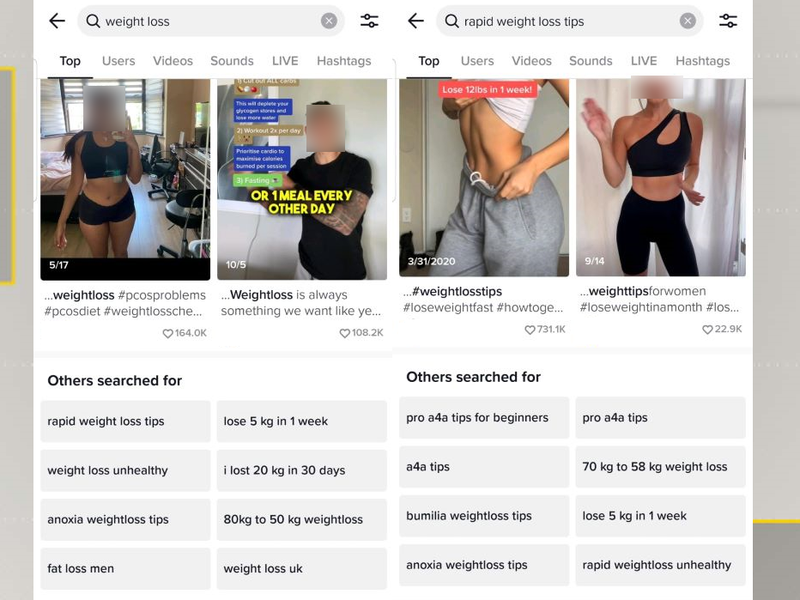

De acordo com uma pesquisa do Center for Countering Digital Hate (CCDH), o TikTok parece estar enviando vídeos sobre distúrbios alimentares e automutilação para crianças a partir dos 13 anos.

A estudo, que analisou o poderoso algoritmo da plataforma, encontrou contas promovendo o suicídio em 2.6 minutos e outras recomendando clipes pró-magreza explícitos em oito.

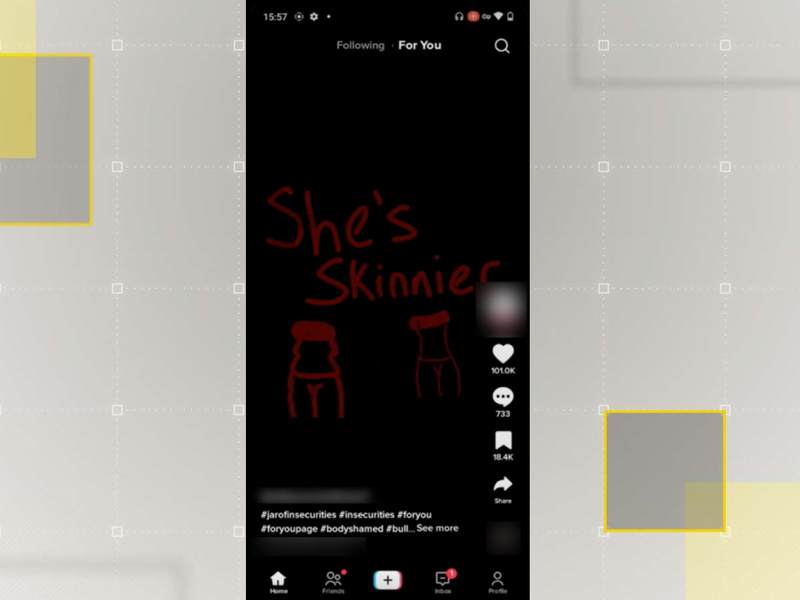

Os pesquisadores descobriram que as páginas para você de contas que eles criaram com características de adolescentes vulneráveis foram inundadas com conteúdo dessa natureza doze vezes mais do que contas padrão.

Isso acendeu novas preocupações sobre a influência do aplicativo em usuários impressionáveis.

Ele vem como legisladores estaduais e federais nos EUA buscar maneiras de reprimir no TikTok sobre privacidade e medos de segurança, bem como determinar independente da resposta a plataforma é apropriada para adolescentes.

Também segue um série de investigações de setembro até a falha do TikTok em informar sua base de usuários de 25% de 10 a 19 anos de idade que estava processando seus dados sem consentimento ou os fundamentos legais necessários.

Depois disso, a empresa prometeu mudar, mas as últimas descobertas da CCDH sugerir o contrário.

“Os resultados são o pesadelo de todos os pais: os feeds dos jovens são bombardeados com conteúdo prejudicial e angustiante que pode ter um impacto cumulativo significativo em sua compreensão do mundo ao seu redor e em sua saúde física e mental”, escreveu Imran Ahmed, CEO da CCDH, no relatório intitulado Mortal por Design.