Suscitando nuove preoccupazioni sull'influenza della piattaforma sui bambini, una nuova ricerca ha scoperto che il suo algoritmo sta spingendo i video sui disturbi alimentari e l'autolesionismo ai tredicenni.

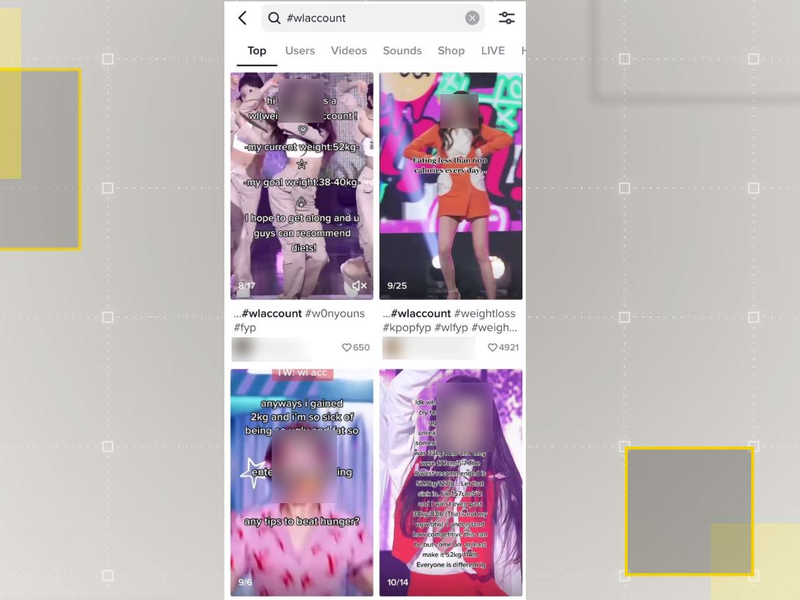

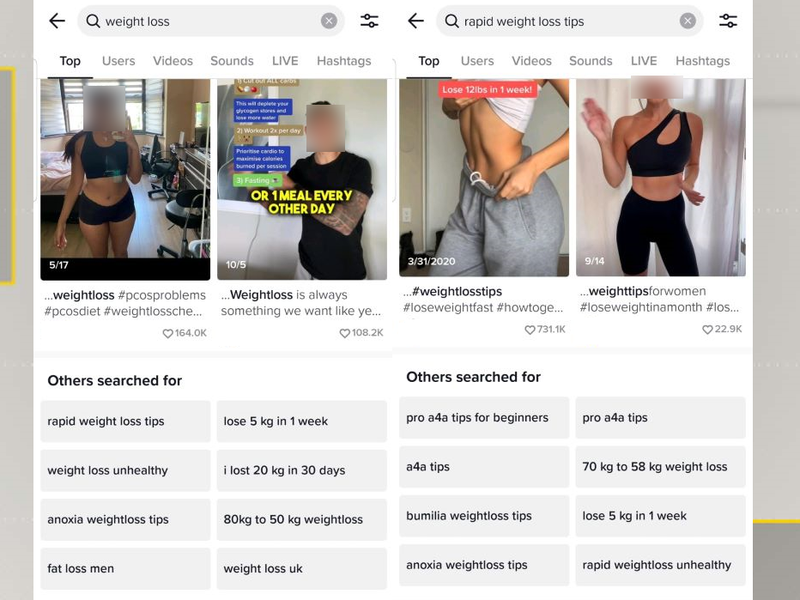

Secondo una ricerca del Center for Countering Digital Hate (CCDH), TikTok sembra spingere video sui disturbi alimentari e l'autolesionismo a bambini di 13 anni.

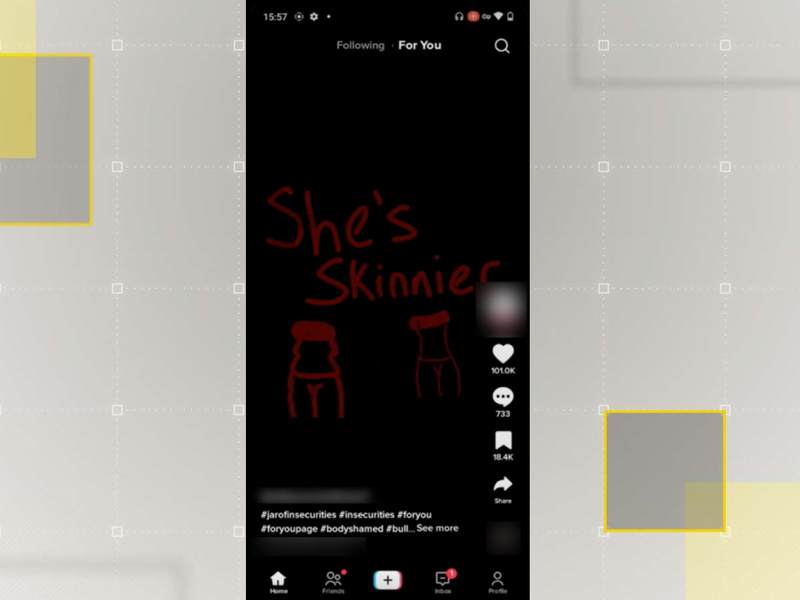

I studio, che ha esaminato il potente algoritmo della piattaforma, ha trovato account che promuovono il suicidio entro 2.6 minuti e altri che raccomandano clip esplicite a favore della magrezza entro otto.

I ricercatori hanno scoperto che le pagine For You degli account che hanno creato con caratteristiche di adolescenti vulnerabili sono state inondate di contenuti di questa natura dodici volte più dei conti standard.

Questo ha scatenato nuove preoccupazioni sull'influenza dell'app sugli utenti impressionabili.

Arriva come legislatori statali e federali negli Stati Uniti cercare modi per reprimere su TikTok per i timori sulla privacy e la sicurezza, oltre a determinare indipendentemente dal fatto la piattaforma è appropriata per gli adolescenti.

Segue anche A serie di indagini da settembre fino all'incapacità di TikTok di informare la sua base di utenti del 25% di 10-19 anni che stava elaborando i loro dati senza il consenso o i necessari motivi legali.

Dopo di che la società ha promesso di cambiare, ma gli ultimi risultati del CCDH suggerire diversamente.

"I risultati sono l'incubo di ogni genitore: i feed dei giovani sono bombardati da contenuti dannosi e strazianti che possono avere un impatto cumulativo significativo sulla loro comprensione del mondo che li circonda e sulla loro salute fisica e mentale", ha scritto Imran Ahmed, CEO di CCDH, nella relazione intitolata Mortale per design.