Generando nuevas preocupaciones sobre la influencia de la plataforma en los niños, una nueva investigación ha descubierto que su algoritmo está promocionando videos sobre trastornos alimentarios y autolesiones a niños de 13 años.

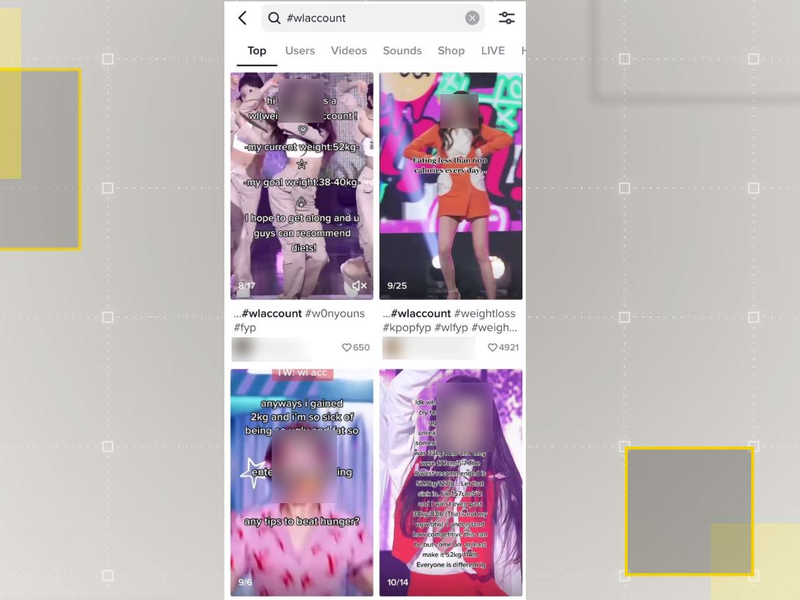

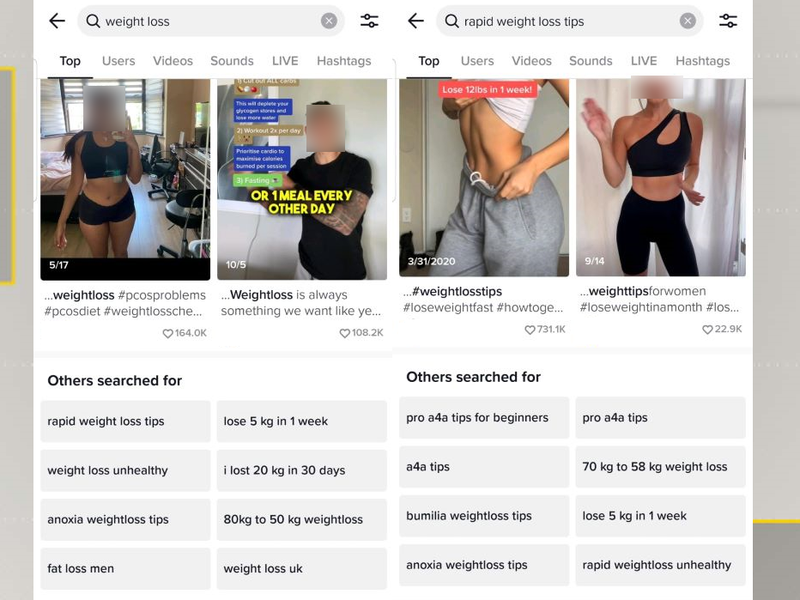

Según una investigación del Centro para contrarrestar el odio digital (CCDH), TikTok parece estar promocionando videos sobre trastornos alimentarios y autolesiones a niños de hasta 13 años.

La estudio , que investigó el poderoso algoritmo de la plataforma, encontró cuentas que promovían el suicidio en 2.6 minutos y otras que recomendaban clips explícitos a favor de la delgadez en ocho.

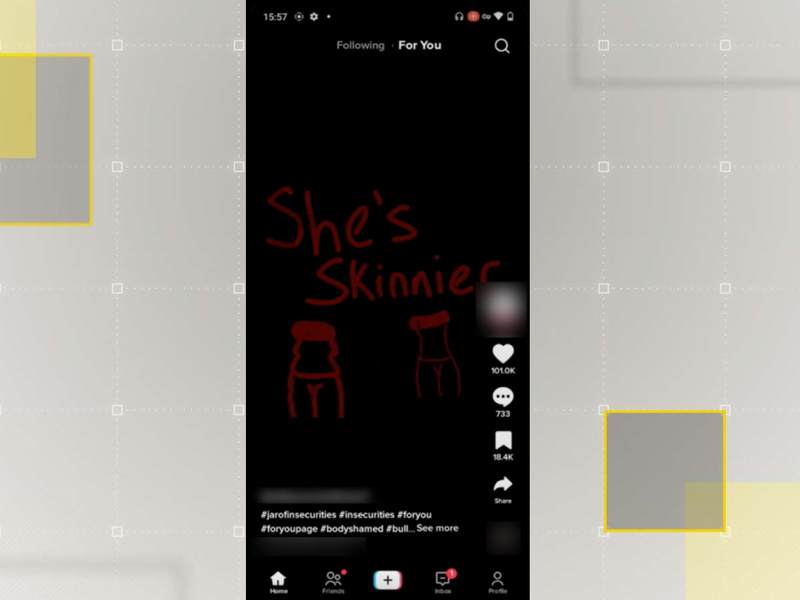

Los investigadores descubrieron que las páginas para ti de las cuentas que crearon con características de adolescentes vulnerables estaban inundadas con contenido de esta naturaleza. doce veces más que las cuentas estándar.

Esto ha provocado nuevas preocupaciones sobre la influencia de la aplicación en los usuarios impresionables.

Viene como legisladores estatales y federales en los EE. UU. buscar formas de reprimir en TikTok sobre los temores de privacidad y seguridad, así como para determinar si o no la plataforma es apropiada para adolescentes.

También sigue un serie de investigaciones desde septiembre hasta que TikTok no informó a su base de usuarios del 25% de 10 a 19 años que había estado procesando sus datos sin consentimiento o sin los fundamentos legales necesarios.

Después de lo cual la empresa prometió cambiar, pero los últimos hallazgos de la CCDH sugerir lo contrario.

"Los resultados son la pesadilla de todos los padres: los feeds de los jóvenes son bombardeados con contenido dañino y desgarrador que puede tener un impacto acumulativo significativo en su comprensión del mundo que los rodea y en su salud física y mental", escribió Imran Ahmed, CEO de CCDH, en el informe titulado Mortal por diseño.